Mistral AI je objavio Mixtral 8x22B, koji postavlja nove standarde za modele otvorenog koda u performansama i učinkovitosti. Model se može pohvaliti robusnim višejezičnim mogućnostima i vrhunskom matematičkom vještinom i kodiranjem.

Mixtral 8x22B radi kao Sparse Mixture-of-Experts (SMoE) model, koristeći samo 39 milijardi od svojih 141 milijarde parametara kada je aktivan.

Osim svoje učinkovitosti, Mixtral 8x22B može se pohvaliti tečnim znanjem više glavnih jezika uključujući engleski, francuski, talijanski, njemački i španjolski. Njegova vještina se proteže u tehnička područja sa snažnim matematičkim i kodnim sposobnostima. Naime, model podržava izvorno pozivanje funkcija upareno s ‘ograničenim izlaznim načinom’, olakšavajući razvoj velikih aplikacija i tehnološke nadogradnje.

Mixtral 8x22B Instruct is out. It significantly outperforms existing open models, and only uses 39B active parameters (making it significantly faster than 70B models during inference). 1/n pic.twitter.com/EbDLMHcBOq

— Guillaume Lample (@GuillaumeLample) April 17, 2024

Sa značajnim kontekstnim prozorom tokena od 64K, Mixtral 8x22B osigurava precizno pozivanje informacija iz opsežnih dokumenata, dodatno privlačan za korištenje na razini poduzeća gdje je rukovanje opsežnim skupovima podataka rutina.

U skladu s poticanjem kolaborativnog i inovativnog okruženja za istraživanje umjetne inteligencije, Mistral AI je izdao Mixtral 8x22B pod licencom Apache 2.0. Ova vrlo popustljiva licenca otvorenog koda osigurava upotrebu bez ograničenja i omogućuje široku primjenu.

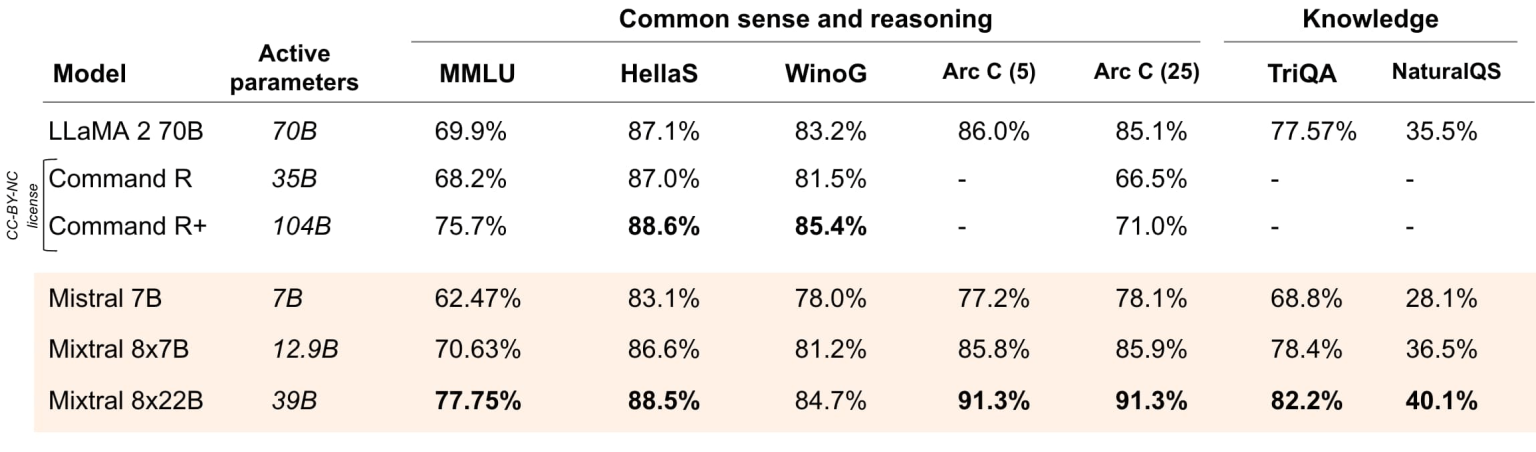

Statistički gledano, Mixtral 8x22B nadmašuje mnoge postojeće modele. U izravnim usporedbama na standardnim industrijskim mjerilima – u rasponu od zdravog razuma, zaključivanja do znanja o predmetu – Mistralova nova inovacija briljira. Brojke koje je objavio Mistral AI pokazuju da Mixtral 8x22B značajno nadmašuje model LLaMA 2 70B u različitim lingvističkim kontekstima kroz kritičko razmišljanje i mjerila znanja:

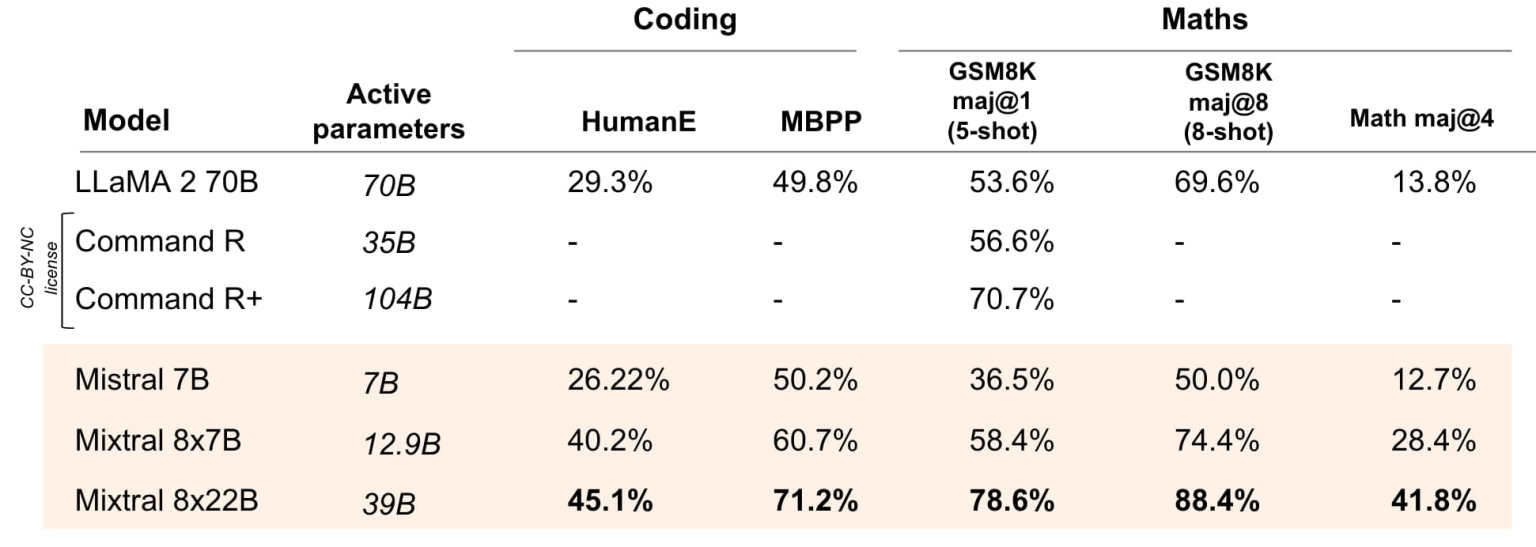

Nadalje, u arenama kodiranja i matematike, Mixtral nastavlja svoju dominaciju među otvorenim modelima. Ažurirani rezultati pokazuju impresivno poboljšanje performansi u matematičkim referentnim vrijednostima, nakon izdavanja instruirane verzije modela:

Potencijalni korisnici i programeri pozivaju se da istraže Mixtral 8x22B na La Plateforme, Mistral AI interaktivnoj platformi. Ovdje se mogu izravno baviti modelom.

U eri u kojoj se uloga umjetne inteligencije neprestano širi, Mixtral 8x22B spoj visokih performansi, učinkovitosti i otvorene pristupačnosti označava značajnu prekretnicu u demokratizaciji naprednih AI alata.

Smrt za ljude.

Treba to probat, super da je Open Source, hvala na clanku.

NEMA otvorenog koda, ne više…bilo je u početku – sada je sve pod kontrolom, a ovo kao open source – možda i pod najvećom kontrolom

Jos jedno skretanje i odvlacenje paznje. Umesto da razmisljamo koji ce nam vrag ta AI (jer smo ziveli i bez nje sasvim dobro), mi sad treba da mislimo koja je najbolja, i hocu da imam (ugradim) najbolju!

I cilj transhumanizma ce biti ostvaren a da ljudi budu “srecni”, jer nisu uzeli “oficijelnu” i glupu AI, vec AI otvorenog koda, koja je mnogo pametnija i bolja itd, itd, eh kad smo budale onda se sa nama moze tako…